对于初学者而言,Hadoop作为大数据处理的核心框架,其学习资料的选择至关重要。《Hadoop基础教程》PDF版本因其系统性和易用性成为许多入门者的首选,而图灵出版社作为国内知名的计算机技术图书出版机构,其推出的相关教程更是备受关注,本文将围绕“Hadoop基础教程pdf 图灵”这一关键词,详细解读该教程的核心内容、学习路径及实用价值,帮助读者高效掌握Hadoop基础知识。

Hadoop基础教程PDF的核心内容结构

图灵出版社的《Hadoop基础教程》PDF通常以“理论+实践”为主线,内容循序渐进,适合零基础读者,全书一般分为基础概念、核心组件、实战操作及进阶应用四个部分,具体模块如下:

大数据与Hadoop概述

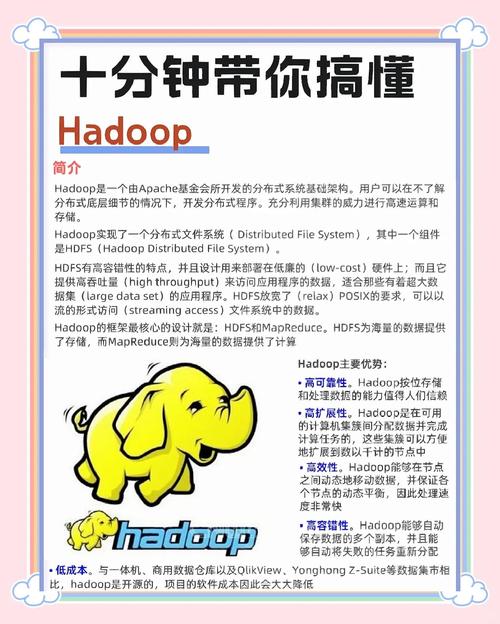

作为开篇章节,教程首先会介绍大数据的背景、特征(4V:Volume、Velocity、Variety、Value)以及传统数据处理方式的局限性,从而引出Hadoop的产生背景和核心优势——分布式存储与计算,这部分内容旨在帮助读者建立对大数据生态的整体认知,理解Hadoop在其中的定位。

Hadoop核心组件详解

Hadoop的核心是其生态系统,教程会对关键组件进行深入浅出的讲解:

- HDFS(分布式文件系统):作为Hadoop的存储基石,HDFS的架构(NameNode、DataNode)、数据块(Block)机制、副本策略等内容会被重点分析,并通过示意图直观展示数据读写流程。

- MapReduce:作为Hadoop的并行计算模型,MapReduce的“分而治之”思想、Map阶段与Reduce阶段的工作原理、数据分区与排序机制等是核心知识点,教程通常会结合“WordCount”等经典案例,逐步拆解代码实现逻辑。

- YARN(资源调度器):作为Hadoop的资源管理框架,YARN的架构(ResourceManager、NodeManager)、任务调度流程(如FIFO、Capacity Scheduler)等内容会帮助读者理解集群资源分配的底层逻辑。

Hadoop环境搭建与实战操作

理论结合实践是技术学习的关键,该教程PDF会提供详细的Hadoop集群搭建步骤,包括:

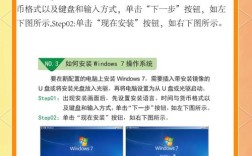

- 单机模式与伪分布式环境配置:以Linux系统为基础,讲解JDK安装、Hadoop下载解压、环境变量配置(如

HADOOP_HOME、PATH)、核心配置文件修改(core-site.xml、hdfs-site.xml等)的全过程,并附带常见问题解决方案(如端口冲突、权限问题)。 - 分布式集群部署:介绍多节点集群的规划(如Master节点与Worker节点的分工)、SSH免密登录配置、集群启动与监控命令(

start-dfs.sh、jps命令检查进程状态)等操作,让读者掌握真实环境的部署方法。

生态工具与进阶应用

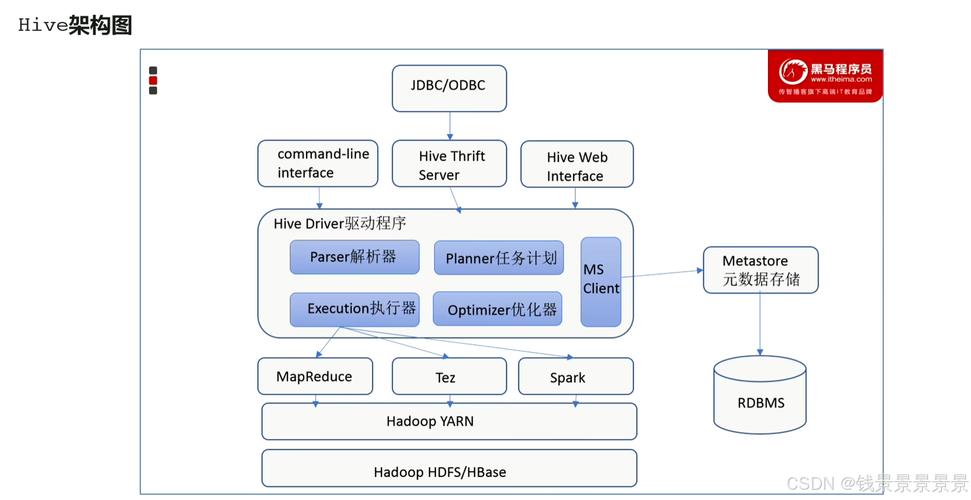

除了核心组件,教程还会拓展Hadoop生态中的常用工具,如:

- Hive:数据仓库工具,讲解其SQL-like查询语言(HiveQL)的使用,以及如何将结构化数据存储在HDFS中进行分析。

- HBase:列式数据库,适用于海量实时查询场景,介绍其数据模型(表、行、列族)与基本操作。

- ZooKeeper:分布式协调服务,说明其在Hadoop集群中的角色(如NameNode高可用性支持)。

学习Hadoop基础教程的实用价值

选择图灵出版社的《Hadoop基础教程》PDF学习,具有以下优势:

- 系统性强覆盖从基础概念到实战操作的全流程,避免知识点碎片化,适合构建完整的知识体系。

- 案例驱动:每个核心模块均配有实际案例(如日志分析、用户行为统计),读者可通过动手操作加深理解,快速提升实践能力。

- 更新及时:图灵教程通常会紧跟Hadoop版本迭代(如Hadoop 3.x的新特性),确保内容的时效性,避免学习过时的技术细节。

相关问答FAQs

Q1:零基础学习Hadoop,是否需要先掌握Linux和Java?

A1:建议具备基础的Linux操作能力(如命令行、文件管理)和Java编程基础(了解基本语法、面向对象概念),因为Hadoop运行在Linux环境下,且MapReduce编程需要Java实现,若完全没有基础,可先通过图灵的《Linux基础教程》和《Java核心技术》进行补充学习,再进入Hadoop主教程会更顺畅。

Q2:Hadoop基础教程PDF中的案例代码如何获取?

A2:图灵出版社的官方配套资源通常可在其官网或图书详情页下载,读者可根据书中的指引获取案例源代码、配置文件模板及实验数据集,部分教程还会提供在线实验环境(如Docker容器),方便读者无需搭建本地集群即可完成实践操作。