TensorFlow NLP 学习路线图

学习 NLP 是一个循序渐进的过程,建议按照以下步骤进行:

- 基础准备:掌握 Python 和深度学习基础。

- TensorFlow 核心:了解 TensorFlow/Keras 的基本用法。

- NLP 核心概念:学习文本处理的基本流程(分词、填充、编码等)。

- 经典模型实战:从简单到复杂,实现情感分析、文本分类等任务。

- 高级模型与迁移学习:学习 Transformer、BERT 等现代预训练模型。

- 项目实践:将所学知识应用到实际项目中。

第一部分:基础准备

在开始 TensorFlow NLP 之前,请确保你已经掌握了以下知识:

- Python 编程:熟悉基本语法、数据结构(列表、字典)、函数和类。

- 深度学习基础:了解神经网络、前向传播、反向传播、损失函数、优化器(如 Adam)等概念,吴恩达的深度学习课程是绝佳的入门资源。

- 基础机器学习:了解监督学习、分类、回归等概念。

第二部分:核心教程与资源

这部分是学习的核心,我们将它分为几个阶段。

TensorFlow/Keras 基础

如果你是 TensorFlow 新手,先从这里开始:

- 官方入门教程:

- TensorFlow 教程:这是最权威的资源,建议先完成 "Get Started" 和 "Basic classification" 等入门教程,对 TensorFlow 有一个整体认识。

- Keras 指南:Keras 是 TensorFlow 的高级 API,非常适合快速搭建和训练模型。

NLP 核心概念与文本预处理

这是 NLP 的第一步,也是最关键的一步,你需要学会如何将原始文本转换为模型可以理解的数字。

核心概念:

- 分词:将句子拆分成单词或子词。

- 数字编码:将每个单词映射到一个唯一的整数 ID。

- 填充/截断:由于神经网络需要固定长度的输入,所以要将所有文本序列填充或截断到相同的长度。

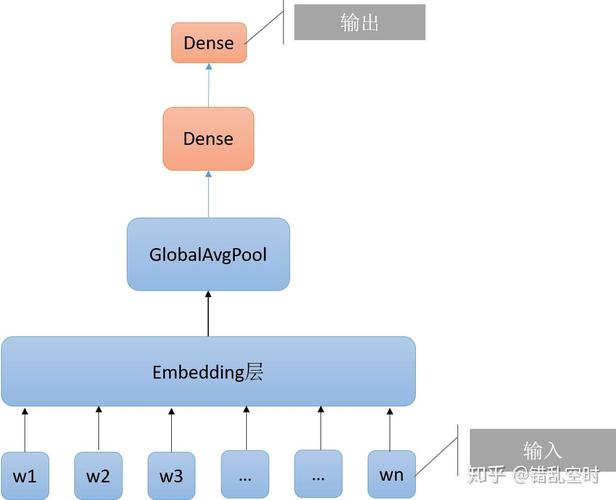

- 词嵌入:将整数 ID 转换为密集的、低维度的向量,这是 NLP 的核心,它能捕捉单词之间的语义关系。

实战教程:

-

官方 NLP 基础教程:

- Load text:这是 必读的第一篇 NLP 教程,它会手把手教你如何使用

tf.data.TextLineDataset加载文本数据,并进行预处理。 - Tokenization and Padding:这篇教程接着上一篇,详细介绍了如何使用

tf.keras.layers.TextVectorization层进行分词、编码和填充,这是现代 TensorFlow 中处理文本的标准方式。

- Load text:这是 必读的第一篇 NLP 教程,它会手把手教你如何使用

-

分词器详解:

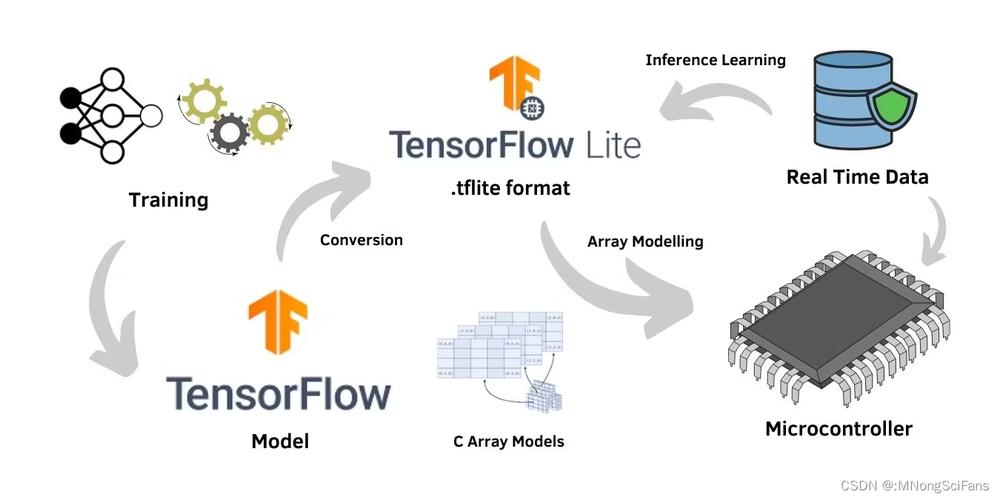

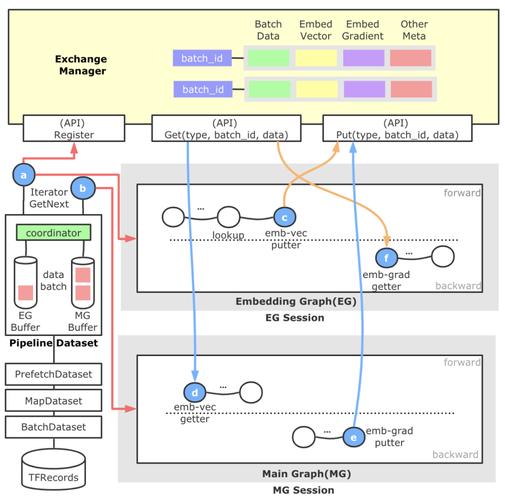

(图片来源网络,侵删)

(图片来源网络,侵删)- Word-based Tokenization:了解基于单词的分词。

- Subword Tokenization (e.g., WordPiece):了解子词分词,这是 BERT 等现代模型使用的技术,能有效处理未登录词。

经典 NLP 模型实战

掌握了预处理之后,就可以开始构建和训练你的第一个 NLP 模型了。

-

文本分类:

- Movie review sentiment analysis:这是 TensorFlow 官方提供的经典情感分析教程,你将学习如何:

- 加载 IMDb 电影评论数据集。

- 使用

TextVectorization进行预处理。 - 构建一个简单的

tf.keras.Sequential模型(包含Embedding层)。 - 训练、评估和预测模型。

- IMDb review classification with LSTM:这篇教程在上一个的基础上,引入了 LSTM (Long Short-Term Memory) 层,这是一种循环神经网络,能更好地处理序列数据,捕捉上下文信息。

- Movie review sentiment analysis:这是 TensorFlow 官方提供的经典情感分析教程,你将学习如何:

-

文本生成:

- Recurrent Neural Networks (RNN) with text:一个非常有趣的教程,你将使用一个简单的 RNN 来学习莎士比亚的写作风格,并生成新的文本,这能让你理解序列到序列 的任务。

高级模型与迁移学习

这是现代 NLP 的精髓,从头训练模型需要大量数据和计算资源,而 迁移学习,特别是使用 预训练模型,是解决这个问题的最佳方式。

-

Transformer 模型简介:

- Transformer model for language understanding:这是一篇非常深入的教程,会教你从零开始实现 Transformer 模型的核心组件(多头注意力机制、编码器、解码器),虽然代码较长,但能让你彻底理解其工作原理。

-

使用 Hugging Face

transformers库 (强烈推荐): Hugging Face 提供了最方便、最强大的预训练模型接口,是业界标准,TensorFlow 与其无缝集成。- Hugging Face Course:这是 必学的免费课程!它由 Hugging Face 官方出品,全面介绍了如何使用其生态系统进行 NLP 任务。

- Chapter 2: Using Hugging Face Models:学习如何加载和使用预训练模型。

- Chapter 3: Fine-tuning a Pre-trained Model:学习如何在自己的数据集上对预训练模型进行微调,这是 NLP 项目中最常见的操作。

- TensorFlow + Hugging Face 教程:

- TensorFlow + Hugging Face:官方文档中关于 TensorFlow 的部分。

- Hugging Face Course:这是 必学的免费课程!它由 Hugging Face 官方出品,全面介绍了如何使用其生态系统进行 NLP 任务。

-

BERT 模型实战:

- BERT text classification:官方教程,教你如何使用 BERT 进行文本分类,这是迁移学习的绝佳实践。

第三部分:项目实践与进阶

理论学习后,通过项目来巩固知识。

项目 Idea

-

情感分析系统:

- 目标:分析 Twitter/微博上关于某个品牌或产品的评论情感(正面/负面/中性)。

- 技术栈:

TextVectorization+ LSTM/GRU 或 BERT。

-

新闻主题分类:

- 目标:将新闻文章自动分类到“体育”、“科技”、“财经”等不同类别。

- 技术栈:使用 BERT 或其他预训练模型进行微调。

-

问答系统:

- 目标:根据给定的上下文,回答问题。

- 技术栈:基于 Transformer 模型(如 BERT)。

-

命名实体识别:

- 目标:从文本中识别出人名、地名、组织机构名等。

- 技术栈:使用 BERT for NER 任务。

进阶资源

- TensorFlow Hub:https://tfhub.dev/

一个包含大量预训练模型(包括 NLP 模型)的库,你可以像调用一个 URL 一样轻松地加载和使用这些模型,非常方便。

- TensorFlow Model Garden:https://github.com/tensorflow/models

TensorFlow 官方实现的最新、最先进的模型代码库,如果你想研究 SOTA (State-of-the-art) 模型的实现,这里是最好的地方。

- 书籍推荐:

- 《Natural Language Processing with Transformers》:由 Hugging Face 团队编写,系统介绍了 Transformer 模型的理论与实践。

总结与建议

- 动手实践:NLP 是一门实践性很强的学科,不要只看不练,跟着教程敲代码,并尝试修改参数、改变模型结构,观察结果的变化。

- 从简到难:先完成简单的文本分类,再挑战文本生成,最后尝试使用 BERT 等复杂模型,每一步都建立在对前一步的深刻理解之上。

- 拥抱社区:遇到问题时,多查阅官方文档、Stack Overflow 和 GitHub Issues,Hugging Face 和 TensorFlow 的社区都非常活跃。

- 关注前沿:NLP 领域发展迅速,多关注顶会(如 ACL, EMNLP, NeurIPS)的论文和像 Hugging Face 这样的技术博客,了解最新的模型和技术。

祝你学习顺利,在 TensorFlow NLP 的世界里探索愉快!